Das Magazin der Zukunft - Kostenlos, Futuristisch, Genial.

Microsoft verklagt Entwickler wegen Missbrauchs von KI-Technologie

Microsoft hat vor kurzem eine Klage aktualisiert, in der vier multinationalen Entwicklern vorgeworfen wird, Sicherheitsschutzmaßnahmen umgangen und die KI-Tools des Unternehmens missbräuchlich verwendet zu haben, um täuschend echte Pornografie mit Prominenten und andere schädliche Inhalte zu erstellen. In einem Blogbeitrag gab der Technologiekonzern bekannt, dass alle vier Entwickler Mitglieder des Cyberkriminalitätsnetzwerks Storm-2139 sind. Die namentlich genannten Angeklagten tragen Spitznamen, die an alte Hackerfilme aus den frühen 2000er Jahren erinnern: Arian Yadegarnia, alias „Fiz“ aus dem Iran; Alan Krysiak, alias „Drago“ aus dem Vereinigten Königreich; Ricky Yuen, alias „cg-dot“ aus Hongkong; und Phát Phùng Tấn, alias „Asakuri“ aus Vietnam.

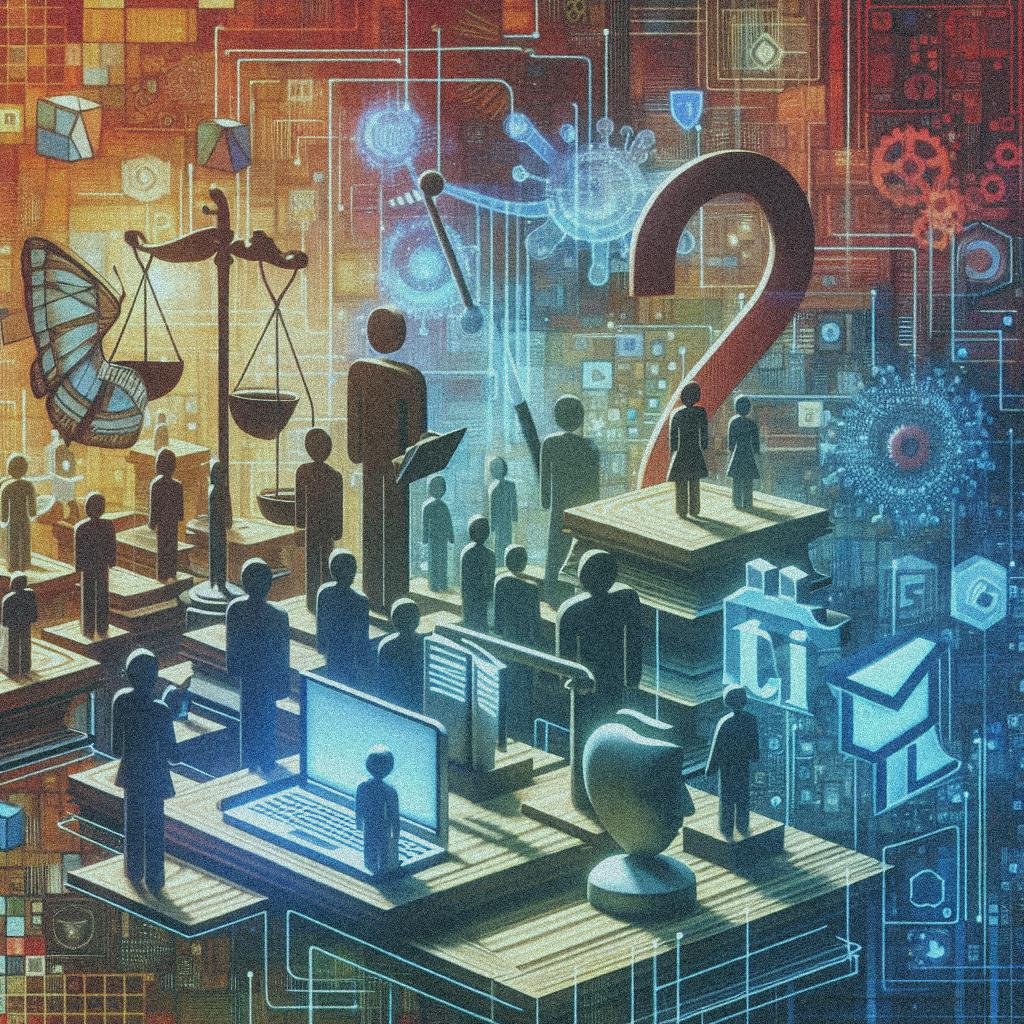

In dem Blogbeitrag wird Storm-2139 in drei Kategorien unterteilt: „Schöpfer, Anbieter und Nutzer“. Diese zusammengenommene Gruppe bildet einen dunklen Marktplatz, der auf dem Jailbreaking und der Modifikation der Microsoft-KI-Tools basiert, um illegales oder destruktives Material zu generieren. „Die Schöpfer entwickelten die illegalen Werkzeuge, die den Missbrauch der KI-gestützten Dienste ermöglichten“, erklärt Microsoft und fügt hinzu, dass die „Anbieter diese Werkzeuge modifizierten und sie an Endnutzer mit unterschiedlichen Service- und Zahlungsstufen bereitstellten“. „Schließlich verwendeten die Nutzer diese Werkzeuge, um rechtswidrige synthetische Inhalte zu generieren, oft mit Fokus auf Prominenten und sexuellen Bildern.“

Die Zivilklage wurde ursprünglich im Dezember eingereicht, wobei alle spezifischen Angeklagten lediglich als „John Doe“ aufgeführt wurden. Mit neuen Erkenntnissen aus Microsofts Untersuchung über Storm-2139 hat das Unternehmen entschieden, einige der vermeintlichen Übeltäter zu entlarven. Die Identität weiterer Beteiligter bleibt jedoch aus laufenden Ermittlungen ungenannt; das Unternehmen teilte mit, dass mindestens zwei von ihnen Amerikaner seien. Microsoft begründet diesen Schritt mit dem Ziel der zukünftigen Abschreckung: „Wir verfolgen diese rechtlichen Schritte gegen identifizierte Angeklagte, um ihr Verhalten zu stoppen, ihren illegalen Betrieb weiter zu zerschlagen und andere abzuschrecken, die beabsichtigen, unsere KI-Technologie zu weaponisieren.“

Dies ist ein bemerkenswerter Schritt des Technologiegiganten Microsoft, der offenbar nicht zulassen möchte, dass seine generativen KI-Tools für offensichtliche, schädliche Inhalte missbraucht werden, wie beispielsweise nicht einvernehmliche Fake-Pornografie von realen Personen. Angesichts der weltweiten Reputation und Ressourcen eines Unternehmens wie Microsoft ist die rechtliche Belastung ein effektives Mittel zur Abschreckung.

Microsoft berichtet, dass der rechtliche Druck bereits Veränderungen innerhalb der Storm-2139-Gruppe bewirkt hat. Mit der „Beschlagnahme“ der Webseite des Netzwerks und der anschließenden Offenlegung der Klageunterlagen im Januar kam es zu einem unmittelbaren Reaktionsverhalten der Akteure, wobei einige Mitglieder der Gruppe begannen, gegeneinander auszuschließen und den Finger zu zeigen.

Gleichzeitig, so Gizmodo, befindet sich Microsofts Entscheidung, gegen vermeintliche Missbrauchsakteure seiner Technologien vorzugehen, in einem grauen Bereich der andauernden Debatte über die Sicherheit von KI und darüber, wie Unternehmen den Missbrauch von KI begrenzen sollten. Einige Unternehmen, wie Meta, haben sich dazu entschieden, ihre neuartigen KI-Modelle als Open Source bereitzustellen – ein dezentrales Vorgehen, das jedoch einige Experten als Risiko sehen, da es Bösewichten ermöglichen könnte, fortschrittliche KI-Technologie unbeobachtet zu nutzen.

Microsoft verfolgt hingegen einen gemischten Ansatz: einige Modelle werden geöffnet und andere bleiben hinter verschlossenen Türen. Trotz aller Bemühungen des Unternehmens, sichere und verantwortungsvollen Einsatz von KI zu garantieren, haben Kriminelle weiterhin Wege gefunden, diese Schutzmaßnahmen zu umgehen und von missbräuchlicher Verwendung zu profitieren. Da sich Microsoft in seiner umfassenden KI-Strategie weiter voranbewegt, kann das Unternehmen nicht allein auf rechtliche Mittel setzen, um der schädlichen Ausbeutung seiner KI-Tools entgegenzuwirken – besonders in einem deregulierten Umfeld, in dem die Gesetzgebung nicht Schritt halten kann mit den komplexen Herausforderungen von KI-Schäden und -Missbrauch.

„Während Microsoft und andere Systeme eingerichtet haben, um den Missbrauch von generativer KI zu verhindern, funktionieren diese Schutzmechanismen nur, wenn die technologischen und rechtlichen Systeme sie effektiv durchsetzen können“, merkt Ina Fried von Axios an.